Apple planea implementar una nueva función de software que escanea las imágenes y videos en iPhones, iPads y cuentas de iCloud en un intento de detectar material ilegal de abuso infantil. El Financial Times informó que dos investigadores de seguridad que participaron en la reunión virtual dijeron que este sistema propuesto conocido como “neuralMatch” fue detallado a algunos académicos estadounidenses a principios de esta semana.

Esto, por supuesto, despertó las alarmas para los investigadores de seguridad, ya que podría ser una pendiente resbaladiza, abriendo la puerta a la vigilancia de los dispositivos personales de millones de personas. Este es un gran cambio con respecto a la postura anterior de Apple al otorgar acceso a las fuerzas del orden, especialmente cuando se enfrentó con el FBI en 2016, donde la agencia solicitó acceso al iPhone de un sospechoso de terrorismo. El director ejecutivo de la empresa, Tim Cook, dijo en ese momento que la solicitud del FBI era “escalofriante” e indudablemente crearía una puerta trasera para una mayor vigilancia del gobierno.

En una publicación de blog, Apple confirmó la función como parte de un conjunto de medidas de seguridad infantil que agregará a las próximas actualizaciones de iOS 15, iPadOS 15, watchOS 8 y macOS Monterey. Su enfoque principal parece ser frenar la propagación de material de abuso sexual infantil (CSAM) en línea, al menos en sus propios dispositivos; los tres cambios principales serán la adición de detección de CSAM a Messages, Siri y Search, e iCloud. Por el momento, la actualización de CSAM solo se implementará en dispositivos Apple en los EE. UU.

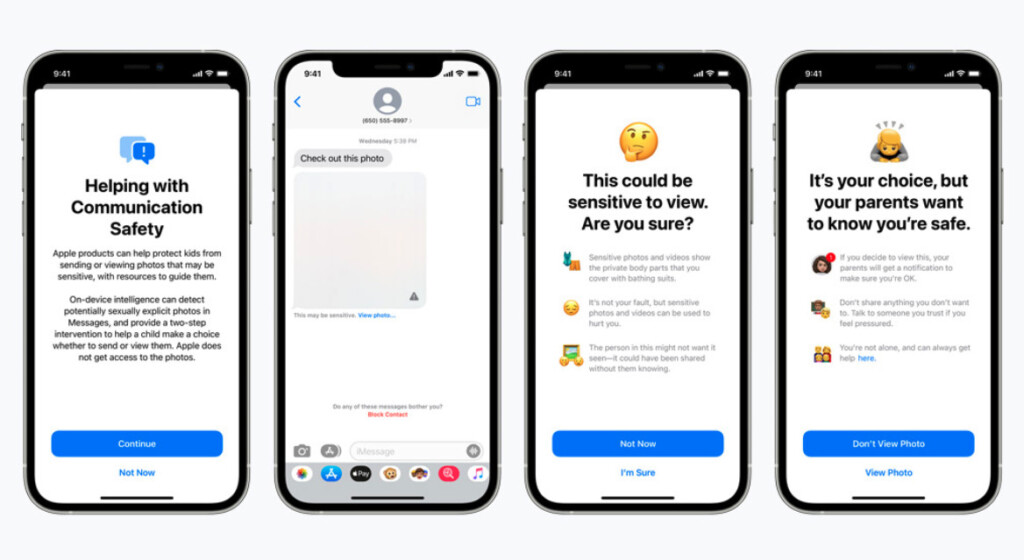

En Mensajes, las nuevas herramientas advertirán a los niños y a sus padres cuando reciban o envíen fotos sexualmente explícitas. El contenido se verá borroso y los usuarios deberán confirmar si realmente quieren verlo. La aplicación utilizará el aprendizaje automático en el dispositivo para analizar los archivos adjuntos de imágenes y determinar si una foto contiene CSAM, y Apple asegura que no tendrán acceso a los mensajes.

La detección de CSAM también se utilizará en iOS y iPadOS para escanear imágenes almacenadas en iCloud Photos, y reportará cualquier imagen de abuso infantil al Centro Nacional para Niños Desaparecidos y Explotados (NCMEC), que está trabajando en colaboración con Apple para esta iniciativa. “Antes de que una imagen se almacene en Fotos de iCloud, se realiza un proceso de comparación en el dispositivo para esa imagen con los hashes CSAM conocidos”, escribió Apple en su publicación de blog. “Este proceso de coincidencia está impulsado por una tecnología criptográfica llamada intersección de conjuntos privados, que determina si hay una coincidencia sin revelar el resultado”.

Otra tecnología llamada “umbral para compartir secretos” hace que la empresa no pueda ver el contenido, a menos que una persona cruce un umbral no especificado de contenido CSAM. Si se supera el umbral, se elaborará un informe que Apple revisará manualmente antes de deshabilitar la cuenta del usuario y enviar el informe al NCMEC.

Por último, Siri y Search se ampliarán para proporcionar orientación y señalar a los usuarios los recursos adecuados si desean informar sobre contenido potencial de CSAM. Además, ambas funciones también intervendrán cuando los usuarios busquen contenido o material relacionado con CSAM. “Estas intervenciones explicarán a los usuarios que el interés en este tema es dañino y problemático, y proporcionarán recursos de los socios para obtener ayuda con este problema”, señaló Apple.

(Fuentes: Apple, FT, Engadget // Imagen: AP / Luca Bruno)