De nieuwe kinderbeveiligingstools van Apple, die in eerste instantie een heel goed idee leken, hebben de afgelopen week nogal wat opschudding veroorzaakt in de technische wereld. Het bedrijf kondigde de functie op 6 augustus aan en is momenteel alleen van toepassing op de Verenigde Staten (VS), maar het is een update op platformniveau, wat betekent dat het onderdeel zal zijn van iOS, macOS, watchOS en iPadOS. alle landen bereiken. waarin Apple actief is. Of het bedrijf de functie in een land kan inschakelen, hangt natuurlijk af van de vraag of de wetten van dat land dergelijke functies toestaan. Maar voordat we aan dat alles…

Hoe werkt het?

Materiaal voor seksueel misbruik van kinderen, of CSAM, is een probleem dat bijna net zo oud is als het internet zelf. Regeringen over de hele wereld hebben dit willen aanpakken en zijn daar tot op zekere hoogte in geslaagd. Maar het blijft nog steeds. Dus voegt Apple nieuwe algoritmen toe aan zijn platforms, die afbeeldingen op iPhones, iPads, Macs, Apple Watches, iMessage en in iCloud zullen scannen om afbeeldingen te detecteren die in de CSAM-categorie vallen. Overtredende gebruikers zullen uiteindelijk worden gemeld aan de autoriteiten.

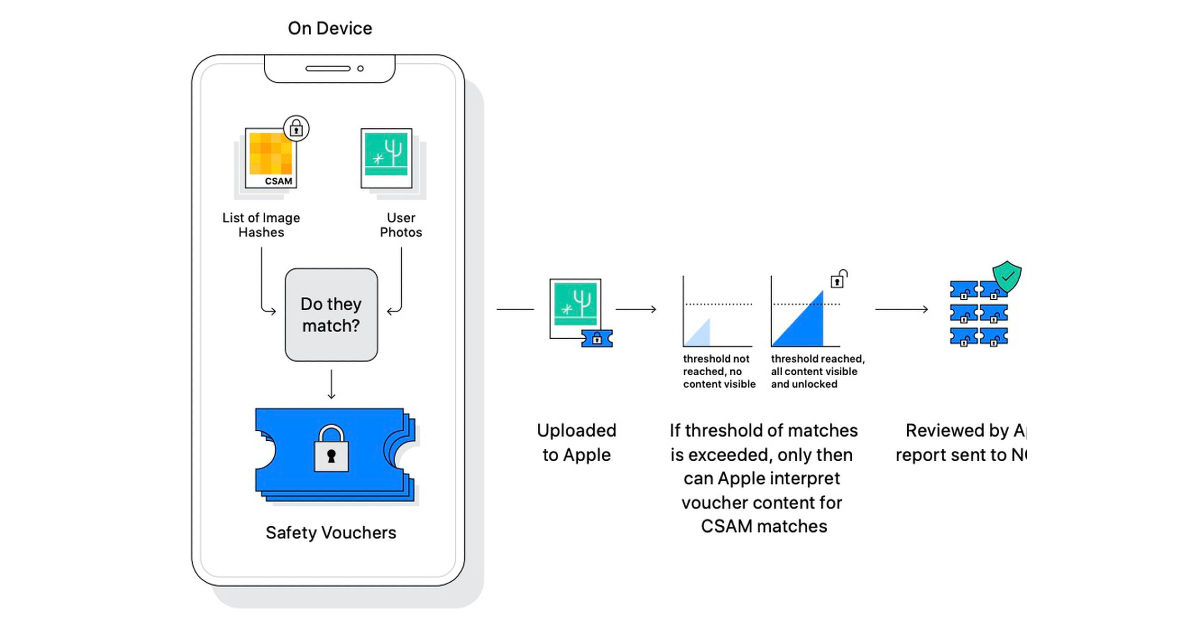

“CSAM-detectie stelt Apple in staat iCloud-gebruikers nauwkeurig te identificeren en rapporteren die bekend materiaal voor seksueel misbruik van kinderen (CSAM) opslaan in hun iCloud-foto’s-accounts. Accounts die een drempelaantal afbeeldingen overschrijden die overeenkomen met een bekende database van CSAM-afbeeldingshashes, worden gemarkeerd door Apple-servers, zodat Apple relevante informatie kan verstrekken aan het National Center for Missing & Exploited Children (NCMEC)”, aldus het bedrijf. document.

Bovendien verklaarde Apple dat het risico dat het systeem een account ten onrechte zou markeren “extreem laag” was. “De drempel is gekozen om een extreem lage kans (1 op 1 miljard) te geven dat een bepaald account verkeerd wordt gemarkeerd”, zegt het document.

Daarnaast heeft Apple ook aangegeven rekening te houden met de privacy van gebruikers. Wat betekent dat het bedrijf geen toegang heeft tot uw afbeeldingen. Kortom, het systeem vergelijkt de afbeeldingen op uw apparaten en iCloud met een vooraf geselecteerde database met CSAM-afbeeldingen. Het voegt een cryptografische handtekening toe aan elke afbeelding op uw apparaat en afbeeldingen die overeenkomen met de database worden geïdentificeerd door hun handtekening. Een menselijke beoordeling zal worden uitgevoerd in het geval dat een afbeelding overeenkomt en de gebruiker zal worden geïnformeerd.

Als het gaat om de privacy van gebruikers, is Apple misschien wel de meest vertrouwde van alle Big Tech-bedrijven ter wereld. Het is echter een feit dat dit systeem in uw apparaten wordt ingebouwd en elke afbeelding op uw apparaat scant, ongeacht wat ze zijn. Gebruikers weten niet welke afbeeldingen zich in de CSAM-database bevinden en weten niet wanneer een afbeelding beledigend wordt bevonden.

“Er zijn twee hoofdfuncties die het bedrijf op alle Apple-apparaten wil installeren. Een daarvan is een scanfunctie die alle foto’s scant terwijl ze worden geüpload naar iCloud-foto’s om te zien of ze overeenkomen met een foto in de database met bekend seksueel misbruik van kinderen (CSAM) die wordt beheerd door het National Center for Missing Children. and Exploited (NCMEC). De andere functie scant alle iMessage-afbeeldingen die zijn verzonden of ontvangen door kinderaccounts – dat wil zeggen accounts die zijn aangemerkt als eigendom van een minderjarige – op seksueel expliciet materiaal en, als het kind jong genoeg is, de ouders op de hoogte stellen wanneer het wordt gevonden. . Ouders kunnen deze functie in- of uitschakelen”, schreef de Electronic Frontier Foundation (EFF) in een blogpost.

Waarom is dit een privacykwestie?

Zoals de EFF-blog aangaf, hebben de nieuwe systemen van Apple misschien het juiste einddoel, maar in wezen komen ze neer op een achterdeur naar de platforms van het bedrijf, iets wat wetshandhavers en regeringen al jaren willen.

“We hebben het al eerder gezegd, en we zeggen het nu nog een keer: het is onmogelijk om een scansysteem aan de clientzijde te bouwen dat alleen kan worden gebruikt voor seksueel expliciete afbeeldingen die door kinderen worden verzonden of ontvangen. Als gevolg hiervan zal zelfs een goedbedoelde poging om zo’n systeem te bouwen belangrijke beloften van messenger-encryptie breken en de deur openen voor bredere misbruiken’, zei de privacy-advocacy-groep in de blog die hierboven is gelinkt.

Daarnaast wees de uitvoerend directeur (CEO) van WhatsApp, Will Cathcart, erop dat overheden het systeem zouden kunnen misbruiken. “Dit is een bewakingssysteem dat door Apple is gebouwd en wordt beheerd en dat heel gemakkelijk kan worden gebruikt om privé-inhoud te scannen op alles wat zij of een overheid willen controleren. Landen waar iPhones worden verkocht, zullen verschillende definities hebben van wat acceptabel is”, aldus Cathcart in een tweet.

Ik heb de informatie gelezen die Apple gisteren heeft gepubliceerd en ik maak me zorgen. Ik vind dit een verkeerde benadering en een tegenslag voor de privacy van mensen over de hele wereld.

Mensen hebben gevraagd of we dit systeem voor WhatsApp gaan gebruiken. Het antwoord is nee.

— Zal Cathcart (@wcathcart) 6 augustus 2021

“In plaats van te focussen op het gemakkelijker maken voor mensen om inhoud te melden die met hen is gedeeld, heeft Apple software gemaakt die alle privéfoto’s op je telefoon kan scannen, zelfs foto’s die je met niemand hebt gedeeld. Dat is geen privacy”, voegde hij eraan toe.

Je zou kunnen stellen dat Cathcart, als onderdeel van de Facebook-machine, niet de juiste persoon is om over privacy te praten, maar het nieuwe systeem van Apple is ook onder vuur komen te liggen van klokkenluider Edward Snowden, politici, activisten, academici en meer.

Bedankt voor het lezen tot het einde van dit artikel. Voor meer informatieve en exclusieve technische inhoud, zoals onze Facebook-pagina