Het nieuwe kinderbeschermingsprogramma, met name het pedofiele fotoanalysesysteem, lijkt niet unaniem. Ongeacht het doel van de maatregelen zijn het de vastgestelde procedures die zich verzetten tegen twee kampen: degenen die de strijd tegen kinderpornografie met alle middelen steunen en degenen die het risico op het gebied van kinderpornografie te groot vinden. .

Dit weekend, Verschillende CEO’s hebben zich ook uitgesproken tegen deze toekomstige functies van iOS 15, door een kennelijk onevenredige schending van individuele vrijheden aan de kaak te stellen of te vrezen voor een mogelijke drift (mensen in de gaten houden, een achterdeur binnengaan, het systeem kapen, enz.). Onder hen vinden we zal karten (WhatsApp), die op Twitter een stap voorwaarts zet en specificeert dat een dergelijk systeem nooit op het platform zal worden geïmplementeerd. OF Tim Sweney (Epic Games) wiens gevecht tegen Cupertino niet zal worden gepresenteerd.

Er is ook een open brief online gepubliceerd, Apple vragen om zijn nieuwe beveiligingstools niet in te zetten, met min of meer bekende ondertekenaars, zoals: Edward Snowden of Matthew Green (die het project donderdagochtend onthulde).

Als reactie hierop heeft Apple zojuist een veelgestelde vraag gepubliceerd met de naam Uitgebreide bescherming voor kinderen, die tot doel heeft de zorgen van gebruikers over privacy weg te nemen en geschillen te onderdrukken. Gezien de omvang van de discussies, luisterde het bedrijf en herinnerde eraan dat de gepresenteerde functies (de CSAM-scan, het iMessage-filter of het Siri-filter) verschillend zijn en elkaar niet overlappen. Sinds we deze functies hebben aangekondigd, hebben veel belanghebbenden, waaronder organisaties voor de veiligheid van kinderen en privacy, hun steun uitgesproken voor deze nieuwe oplossing en hebben sommigen vragen gesteld. Dit document dient om deze vragen te beantwoorden en meer duidelijkheid en transparantie te verschaffen in het proces.

Laten we dat onthouden Donderdagavond kondigde Apple de uitrol aan van nieuwe functies die bedoeld zijn om kinderen te beschermen en allerlei vormen van misbruik of aanvallen door seksuele roofdieren te voorkomen.. Het eerste verwijst naar het CSAM-mechanisme (voor materiaal dat seksueel misbruikt van kinderen, dat wil zeggen de mogelijkheid om pedofiele inhoud te detecteren), dat voorlopig alleen van toepassing zal zijn op Amerikaanse iPhones en iPads, met iCloud Photo geactiveerd.

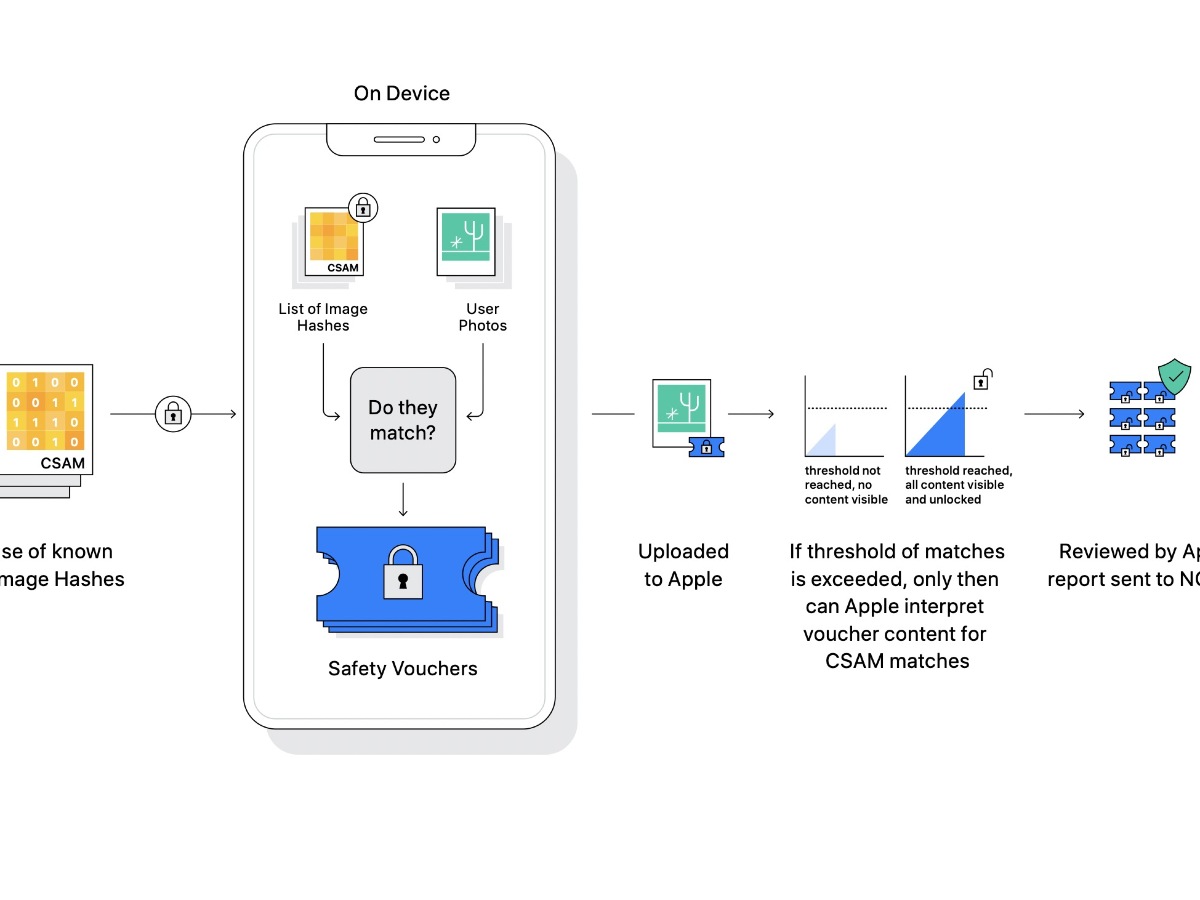

De laatste gebruikt zeer specifieke algoritmen gekoppeld aan een database van hashes geïdentificeerd als pedofiele inhoud. Ze zullen een vergelijking maken direct op het apparaat met de foto’s van de gebruiker en markeer ze wanneer u ze uploadt naar iCloud-foto’s.

Als de match succesvol is, krijgt de foto een specifieke marker. Na een bepaald aantal keren zal een menselijk team een specifieke procedure controleren en toepassen, waarbij het account en de informatie van een geautoriseerd centrum worden gedeactiveerd. Laten we dat onthouden Cupertino vermeldt niets over een inzet buiten de VS.. Maar dit zou nooit het geval kunnen zijn gezien het aantal betrokken apparaten of simpelweg de verschillen in wetgeving tussen landen.