Eerlijk gezegd heb ik nooit begrepen waarom een smartphone twee of meer camera’s nodig heeft. Nee, het is duidelijk dat het handiger is om macro-foto’s te maken met de macro-module, de superbrede vergroot de dekking en de tele lijkt een optische zoomlens te bieden. Maar in het dagelijks leven maken we geen macrofotografie, je kunt op de oude manier en zonder telelens inzoomen en de gebruikelijke shirik kan worden vervangen door een ultragroothoek. Ik heb het niet eens over lidar, dat in de meeste gevallen geen praktische last heeft. Google heeft dezelfde mening, maar vindt dat een tweede camera toch noodzakelijk is.

Dubbele camera’s kunnen in verschillende scenario’s van pas komen voor een smartphone. Daarnaast is het niet eens zo belangrijk wat voor modules het worden: twee standaardbreedtes, shirik en tele of shirik en superwide. Het belangrijkste is dat het geen lidar is, hoewel het dat over het algemeen wel zal doen, en geen macromodule. Het zal zeker niet werken vanwege de brandpuntsafstand en autofocuskenmerken op objecten.

Een portretfoto maken

Het eerste en misschien wel meest voorkomende scenario voor het gebruik van twee camera’s is het maken van portretfoto’s. Hoewel Google ons zelf heeft laten zien dat het mogelijk is om met een enkele module te fotograferen met achtergrondonscherpte, zorgt een dubbele module voor een betere diepte-indicatie en vergroot het de natuurlijkheid van het frame.

Vergelijk hier twee frames vanuit dezelfde hoek:

De eerste foto is gemaakt met Dual Pixel-technologie. Het splitst programmatisch elke pixel in de array in tweeën en stelt u in staat een afbeelding vanuit twee hoeken vast te leggen. Als gevolg van de overlapping van deze afbeeldingen wordt het volume-effect verkregen, en al daaruit worden de algoritmen afgestoten, die bepalen welk gebied moet worden vervaagd en welk gebied scherp moet blijven.

Bij gebruik van twee camera’s die fysiek op grotere afstand van elkaar zijn geplaatst dan beide delen van een pixel die in tweeën zijn gedeeld, wordt het volume verticaal of horizontaal gevormd. Dit alles zorgt voor een grotere verscheidenheid aan invoergegevens over de diepte van het frame, op basis waarvan de algoritmen het vervagingseffect vormen, wat natuurlijker is bij de juiste overgangen.

Als je niet goed kijkt, is het verschil tussen de twee foto’s bijna onzichtbaar. Maar als je gaat inzoomen op afzonderlijke fragmenten, wordt duidelijk dat dankzij het gebruik van een extra module de helderheid van de foto merkbaar toeneemt. Let op het oor. Bij een foto gemaakt met een enkele camera is de overgang van onderwerp naar achtergrond minder scherp en met een dubbele camera juist meer.

Hoe lidar te vervangen

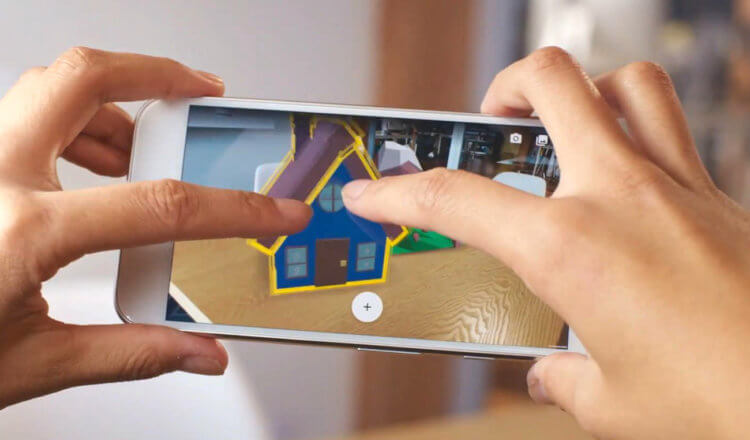

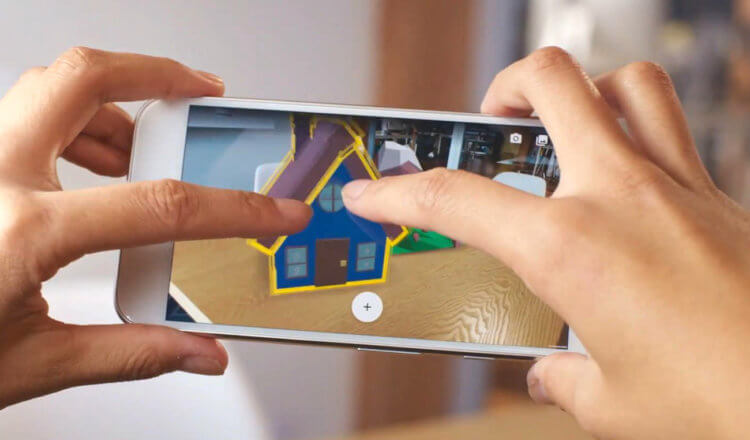

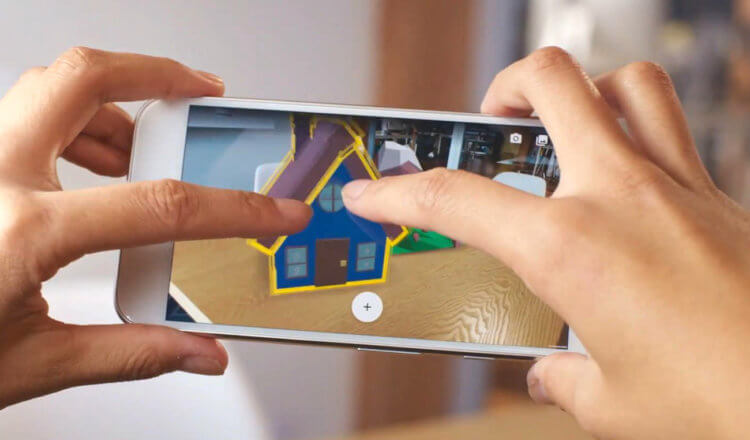

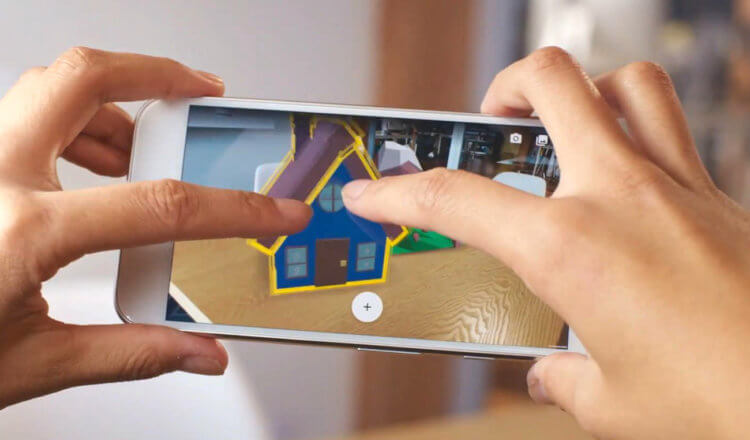

Maar dat is niet alles. Het parallax-effect, dat een extra cameramodule vormt, kan zelfs een lidar vervangen. Tot deze conclusie kwam Google onlangs tijdens experimenten met augmented reality.

Omdat twee camera’s een AR-object vanuit verschillende hoeken bekijken, kunnen ze het nauwkeuriger positioneren door het tussen materiële objecten te plaatsen. In wezen vervult de tweede camera dezelfde functie als de lidar in de iPhone 12 Pro en iPhone 12 Pro Max. Ze schijnt niet door objecten heen, maar dat hoeft ook niet. Door het vermogen om een object te zien alsof het van twee kanten is, plaatst het het duidelijk in de omgeving en laat het niet toe dat het in de “textuur” valt, zoals eerder vaak gebeurde.

Het is vooral interessant dat de technologie om objecten in augmented reality te positioneren geen hardware is, maar software. Google distribueert het via het ARCore-framework, dat beschikbaar is op alle smartphones met GMS-ondersteuning, wat betekent dat bijna elke eigenaar van een apparaat met twee camera’s het kan gebruiken.

Een telelens is echter meer geschikt om het effect van diepte te bepalen. Google maakte het in ieder geval duidelijk door de Pixel 4 alleen uit te rusten met de nieuwe AR-functie. Dit is de enige smartphone in de line-up van de zoekgigant met een telelens. Alle andere modellen, waaronder Pixel 5 en Pixel 4A/4A 5G, zijn uitgerust met breed en superbreed. Daarom zullen ze onafhankelijk moeten worden aangepast. Maar alleen al het feit dat Google een dergelijk effect heeft bereikt zonder LIDAR, wekt oprechte interesse en doet je afvragen waartoe software-algoritmen nog meer in staat zijn.