Apple heeft gisteren verschillende features van iOS 15 / iPadOS 15 aangekondigd met betrekking tot de bescherming van kinderen tegen seksueel misbruik. Deze laatste bieden echter enige verduidelijking (en er zullen er zeker meer volgen).

De eerste verwijst naar het CSAM-mechanisme (voor materiaal dat seksueel misbruik van kinderen maakt, dat wil zeggen het vermogen om pedofiele inhoud op te sporen), dat niet wordt voorlopig alleen gebruikt op Amerikaanse iPhones en iPads. Apple maakt op dit moment geen melding van een uitrol, maar dat zou nooit het geval kunnen zijn gezien het aantal getroffen apparaten of gewoon verschillen in de wetgeving van de landen.

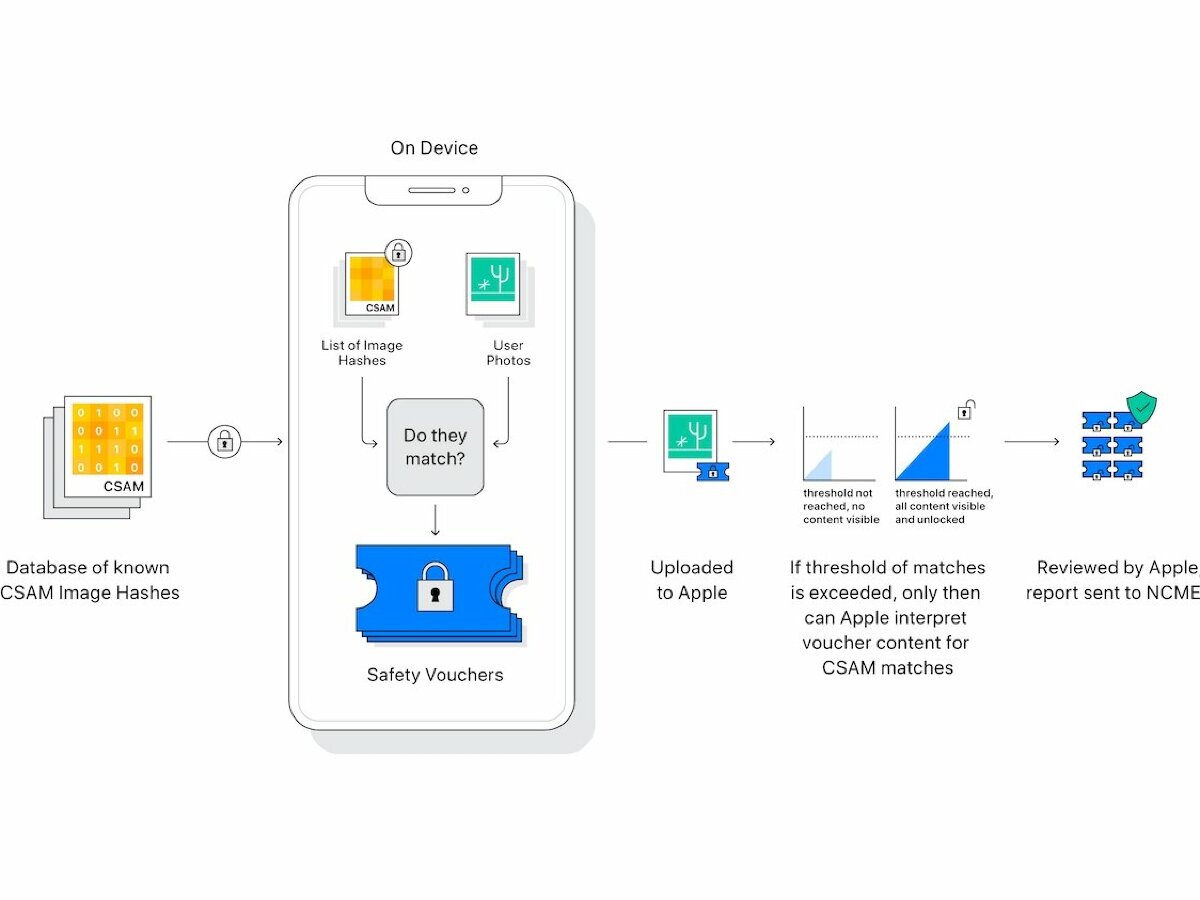

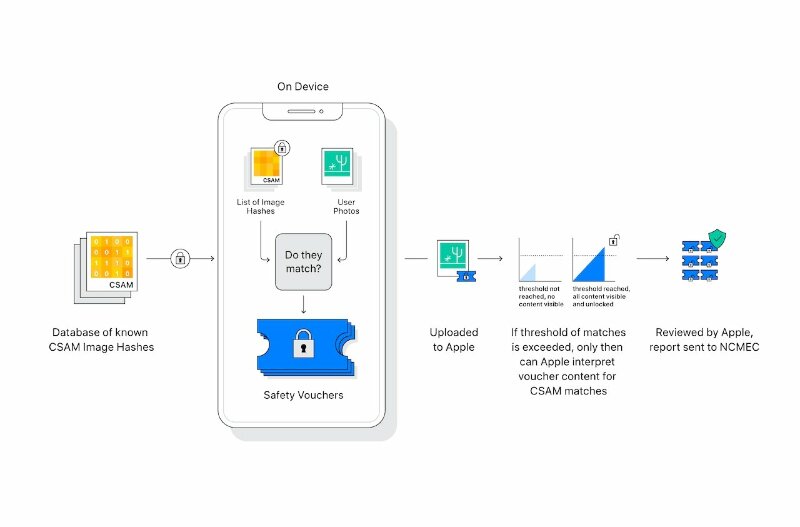

Wat betreft de techniek van Hasjspecificeert ze welke apparaten daadwerkelijk zullen gebruiken zeer nauwkeurige algoritmen met een onleesbare database van bekende hashes (daarom duidelijk geïdentificeerd als pedofiele inhoud) en zal een vergelijking op het apparaat uitvoeren met de eigen foto’s van de gebruiker en deze markeren voordat ze worden geüpload naar iCloud-foto’s.

Als de match succesvol is, de foto krijgt een specifieke bladwijzer. Na een bepaald aantal keren zal een menselijk team een specifieke procedure beoordelen en toepassen, die bestaat uit het deactiveren van het account en het informeren van het Geautoriseerde Centrum (Nationaal centrum voor vermiste en uitgebuite kinderen).

Bovendien bevestigt Cupertino nogmaals geen toegang hebben tot de iPhone, maar alleen tot foto’s die zijn opgeslagen in iCloud. Daarom, gewoon activeer de instelling niet in Instellingen > Apple-ID > iCloud > Foto’s Voor ontsnappen.