Apple heeft de release van de aanstaande detectie van materiaal voor seksueel misbruik van kinderen (CSAM), die minder dan een maand geleden werd aangekondigd, uitgesteld. De verhuizing maakt deel uit van een nieuwe reeks kinderbeschermingsfuncties die het bedrijf van plan is uit te rollen in aankomende updates voor iOS 15, iPadOS 15 en macOS Monterey die naar verwachting ergens dit najaar zullen verschijnen.

“Vorige maand hebben we plannen aangekondigd voor functies die bedoeld zijn om kinderen te helpen beschermen tegen roofdieren die communicatiemiddelen gebruiken om hen te rekruteren en uit te buiten, en om de verspreiding van seksueel kindermisbruikmateriaal te beperken”, zei Apple in een persbericht. “Op basis van feedback van klanten, belangengroepen, onderzoekers en anderen hebben we besloten om de komende maanden meer tijd te nemen om informatie te verzamelen en verbeteringen aan te brengen voordat we deze uiterst belangrijke veiligheidsfuncties voor kinderen vrijgeven.”

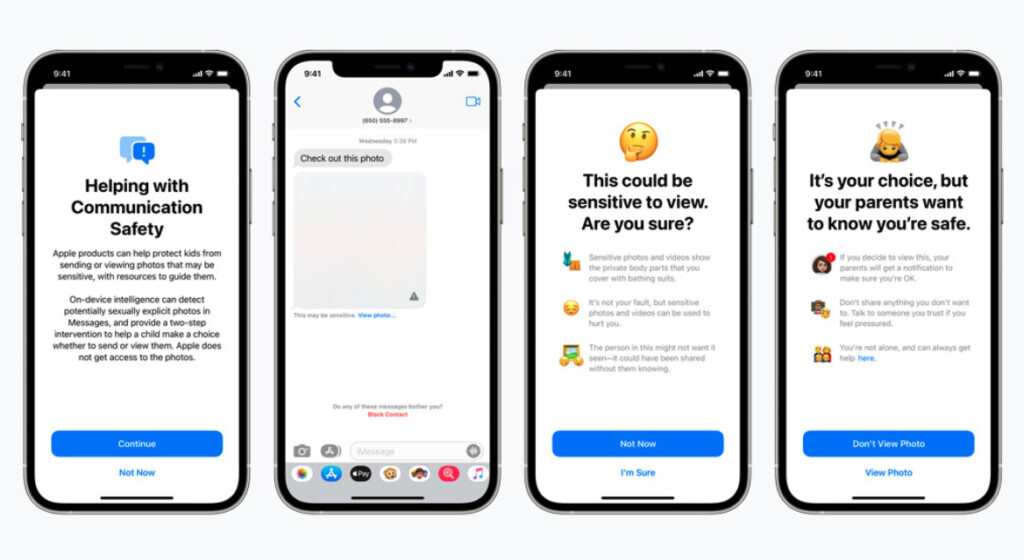

De release bevat drie belangrijke wijzigingen om de detectie van CSAM’s met betrekking tot iCloud Photos, Search en Siri te verbeteren. Volgens Apple gebruiken de functies NeuralHash-technologie die is ontworpen om bekende CSAM’s op het apparaat van een gebruiker te identificeren door hun hashes te vergelijken, en alleen aan Apple te rapporteren als het een drempel van 30 afbeeldingen overschrijdt. Dit gebeurt op het apparaat in plaats van in de cloud, wat volgens Apple privacyvriendelijk blijft omdat ze geen toegang hebben tot de versleutelde gegevens. Er werd ook onthuld dat CSAM-scannen al sinds 2019 wordt uitgevoerd op iCloud Mail.

De detectie van CSAM kreeg weerslag van beveiligingsexperts en privacyadvocaten, waaronder de Electronic Frontier Foundation en de American Civil Liberties Union, vanwege de bezorgdheid dat het in de nabije toekomst vatbaar zou kunnen zijn voor misbruik en mogelijk tot achterdeurtoegang zou leiden. Craig Federighi, Senior Vice President Software Engineering van Apple, verdedigde het nieuwe systeem als een vooruitgang op het gebied van privacy en gaf de publieke reactie de schuld van miscommunicatie en zei dat “berichten behoorlijk door elkaar werden gehaald”.

Een gelekte interne memo onthulde dat Apple zich ervan bewust is dat “sommige mensen misverstanden hebben” over hoe CSAM-scannen werkt. Het bevatte ook een bericht van het National Center for Missing & Exploited Children (NCMEC) waarin critici van de maatregel werden gedestilleerd als “schelle stemmen van de minderheid”. NCMEC is de partner van Apple bij de actie en is verantwoordelijk voor het handmatig beoordelen en bevestigen van gemelde potentiële CSAM’s.

Na de aankondiging van de vertraging reageerde de digitale rechtengroep Fight for the Future door erop te staan dat “er geen veilige manier is om te doen wat [Apple] ze stellen voor.” Regisseur Evan Greer noemt de technologie malware die gemakkelijk kan worden misbruikt om enorme schade aan te richten en zou leiden tot surveillance van Apple-producten.

(Bron: TechCrunch, 9to5mac) [1][2]Macobserver, Arstechnica)